机器学习系列三—评估方法

下面我们来介绍几种评估模型的几种方法。假设我们目前只有一个数据集D={(x1,y1),( x2,y2),...,( xm,ym)}既要训练,又要测试,该如何去做?

评估方法

1.留出法

将数据集D拆分成为两个互斥的集合,一个作为训练集S,另一个作为测试集D。

需要注意的是训练集与测试集的划分数据尽量保持一致性,可以选择分层抽样的方式,根据比例采样。

另外需要注意的是采用按比例分割仍有多种划分方式,单次使用留出法的得到的评估结果往往不够稳定,因此一般采用若干次随机划分、重复实验的方式取平均值后作为留出法的评估结果。

2.交叉验证法

“交叉验证法”先将数据集D划分成k个大小相似的互斥子集。每个子集 Di都尽可能保持数据分布的一致性,即从D中通过分层采样得到。然后,每次选中k-1个子集作为训练集,剩下的那个子集作为测试集,从而可进行k次训练和测试,最终返回的结果是这k次测试结果的均值。

3.自助法

在留出法与交叉验证法中,由于一部分样本用于测试,因此会造成训练集样本数目过少的情况。在这里我们采用自助法(bootstrapping)作为解决方法。在给定的数据集D中,我们对它进行采样产生数据集 D’:每次随机从D中挑选一个样本,将拷贝入 D’中,然后重复m次,这样D中会有一部分样本在D’ 中多次出现,但仍有一部分样本没有在D’中出现过。我们将D’作为训练集,将没有出现过的样本作为测试集。

4.调参

大多数算法都有些参数需要设定,参数配置不同,学得模型的性能的性能往往有显著的差别。因此在模型评估与选择时,除了要对适用学习算法进行选择,还需对算法参数进行设定,这就是通常所说的“调参”。

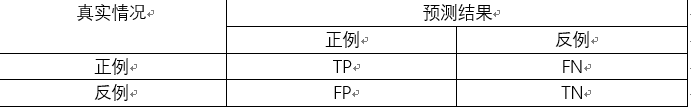

性能度量

下面说一些性能度量常见的符号。

精确率

召回率

准确率

误分配率

ROC曲线全称是“受试者工作特征”(Receiver Operating Characteristic)曲线。它的横轴为“假正例率”(FPR),纵轴为“真正例率”(TPR),两者分别定义为:

AUC(Area Under Curve)被定义为ROC曲线下的面积,显然这个面积的数值不会大于1。随机挑选一个正样本以及一个负样本,分类器判定正样本的值高于负样本的概率就是 AUC 值。

AUC值越大的分类器,正确率越高。

评论已关闭