ES分词器相关

文档相关位置 官网

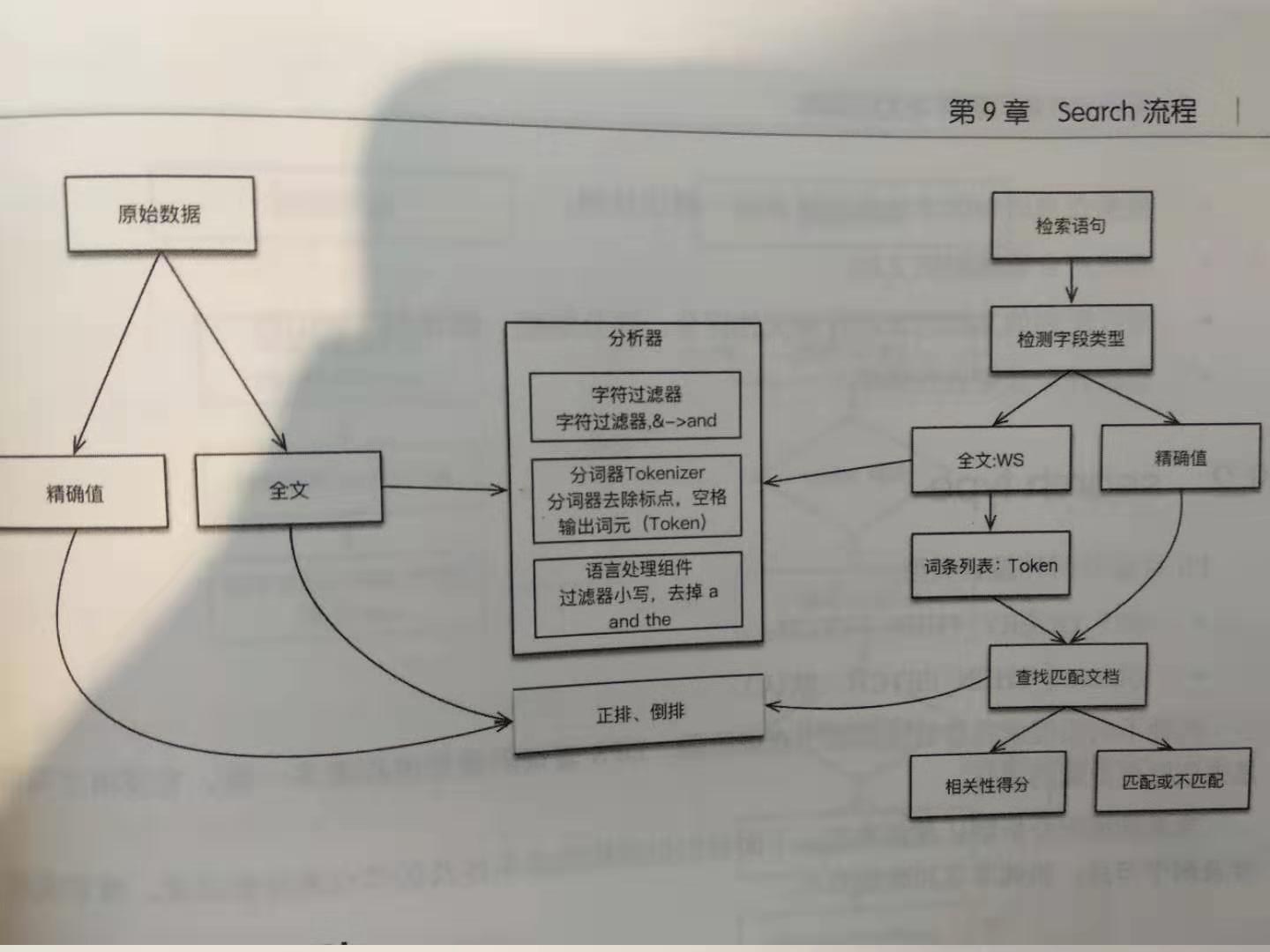

查询与索引流程中Analyzer的位置

我们从上图可以看出,Elasticsearch在倒排索引时会文本会使用设置的分析器,而输入的检索语句也会首先通过设置的相同分析器,然后在进行查询。

Analyzer的组成

分词器是专门处理分词的组件,由三部分组成

- Character Filters(针对原始文本处理,例如去除html)

- Tokenizer(按照规则切分为单词)

- Token Filter(将切分的单词进行加工,小写,删除停用词,增加同义词等)

如何测试

1.直接指定Analyzer进行测试

GET _analyze

{

"analyzer": "standard",

"text": "2 running Quick brown-foxes leap over lazy dogs in the summer evening."

}2.指定索引的字段进行测式

首先你要有这个索引与这个索引字段

POST books/_analyze

{

"field": "title",

"text": "2 running Quick brown-foxes leap over lazy dogs in the summer evening."

}3.自定义分词器进行测试

GET _analyze

{

"tokenizer": "standard",

"filter":["lowercase"],

"text": "2 running Quick brown-foxes leap over lazy dogs in the summer evening."

}一些中文分词器

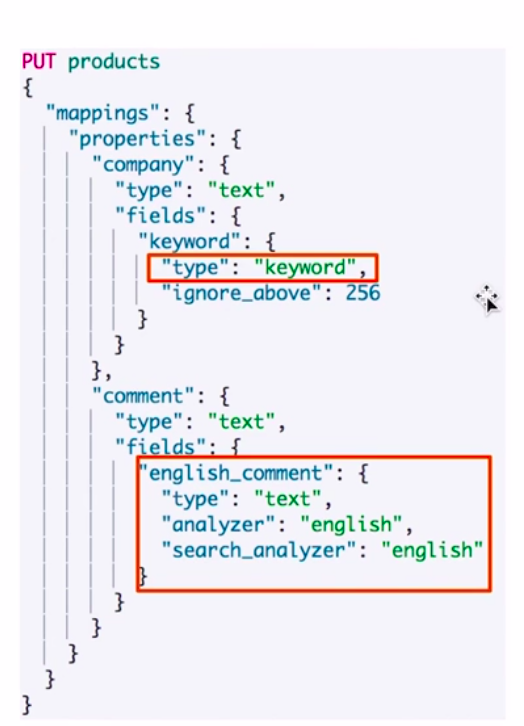

多字段类型

Elasticsearch可以在建立索引时给一个字段增加子字段让其适应不同格式检索,比如可以再子字段中添加设置不同的analyzer

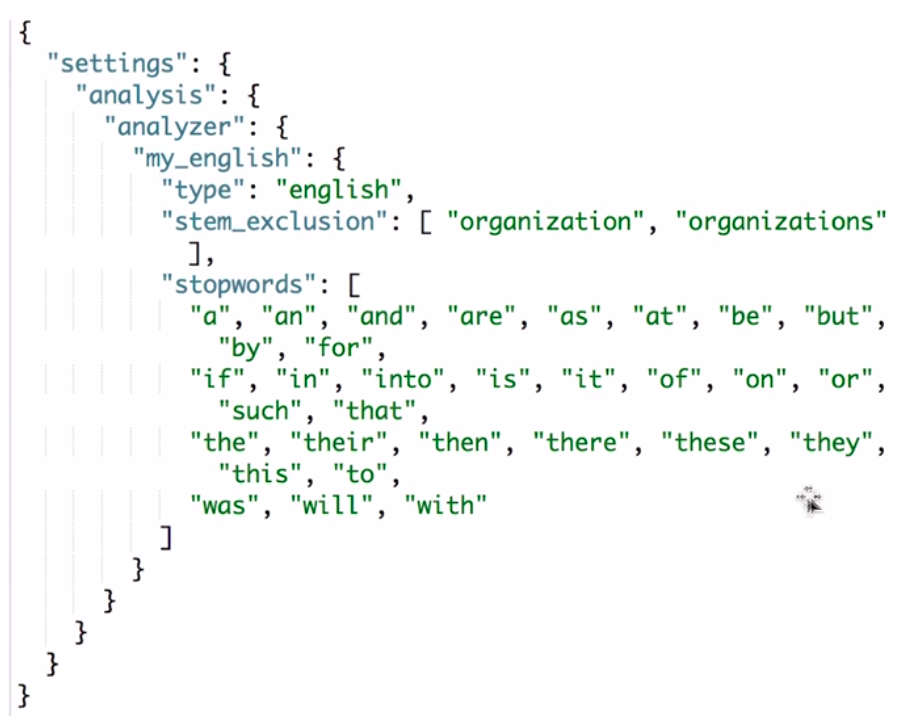

自定义Analyzer

可以在创建索引时定义自己的分词器

PUT my_index

PUT /artists/

{

"settings" : {

"analysis" : {

"analyzer" : {

"user_name_analyzer" : {

"tokenizer" : "whitespace",

"filter" : "pinyin_first_letter_and_full_pinyin_filter"

}

},

"filter" : {

"pinyin_first_letter_and_full_pinyin_filter" : {

"type" : "pinyin",

"keep_first_letter" : true,

"keep_full_pinyin" : false,

"keep_none_chinese" : true,

"keep_original" : false,

"limit_first_letter_length" : 16,

"lowercase" : true,

"trim_whitespace" : true,

"keep_none_chinese_in_first_letter" : true

}

}

}

}

}

评论已关闭