ELK整体架构(系列一)

原创,转发请声明出处啊,亲!

ELK 什么

ELK 是 elastic 公司提供的一套完整的日志收集以及展示的解决方案,是三个产品的首字母缩写,分别是 ElasticSearch、Logstash 和 Kibana。

ElasticSearch 简称 ES,它是一个实时的分布式搜索和分析引擎,它可以用于全文搜索,结构化搜索以及分析。它是一个建立在全文搜索引擎 Apache Lucene 基础上的搜索引擎,使用 Java 语言编写。

Logstash 是一个具有实时传输能力的数据收集引擎,用来进行数据收集(如:读取文本文件)、解析,并将数据发送给 ES。

Kibana 为 Elasticsearch 提供了分析和可视化的 Web 平台。它可以在 Elasticsearch 的索引中查找,交互数据,并生成各种维度表格、图形。

Filebeat 是用于转发和集中日志数据的轻量级传送程序。作为服务器上的代理安装,Filebeat 监视您指定的日志文件或位置,收集日志事件,并将它们转发到 Elasticsearch 或 Logstash 进行索引。

Docker 是一个开源的应用容器引擎,让开发者可以打包他们的应用以及依赖包到一个可移植的容器中, 然后发布到任何流行的 Linux 机器上, 也可以实现虚拟化, 容器是完全使用沙箱机制, 相互之间不会有任何接口。

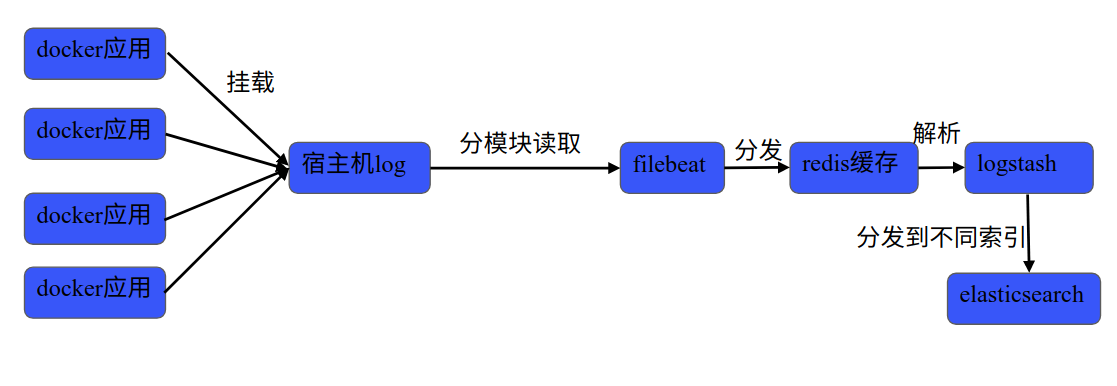

整体架构

我将应用部署在了不同的 docker 容器中,ELK 部署在了不同的宿主机上。

docker-> 宿主机

首先统一了所有应用的日志输出规范,包括日志的划分,输出格式,命名格式等等。然后将 docker 内部应用的日志挂载到了宿主机目录,方便 filebeat 的读取。挂载方式可查看文章《docker 数据卷 》

宿主机 log 日志 ->filebeat

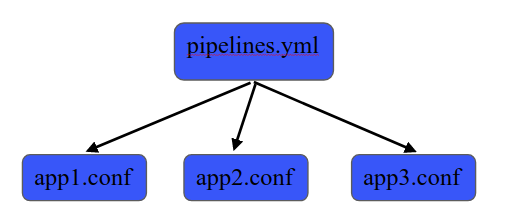

因为应用只部署在了一台宿主机上,所以只采用了一个 filebeat 进行读取,配置文件是分开划分的,整体架构如下:

具体 Filebeat 配置讲解在接下来文章中讲述。

Filebeat->redis

Filebeat 将根据设置 type 的不同将之转发给 redis 的不同库,做缓存。

Redis->Logstash

logstash 开启多个 pipeline 通道分别读取 redis 库中的数据,并将之使用 fileter 解析,最后分发给不同的 elasticsearch 索引。logstash 会在接下来文章中具体讲解。

注:logstash 读取完 redis 库中的数据会将数据删除。

Logstash->Elasticseaarch

logstash 将数据传输到 elasticsearch 中时,会在 es 中自动创建索引,为了使 es 中的新建索引符合一定格式,我使用了 es 新建索引模板,指定新建索引的 Mapping。会在接下来的文章中具体讲解。

Elasticsearch->Kibana

Kibana 通过得到的数据进行统计分析,来实时监控应用的状况。

结论

整体的配置如上述描述,建议大家没事多翻翻官方文档,文档写不清楚的地方,就要自己多配置几次多尝试,毕竟坑都是要一点一点填的。

elastic 官网

https://drugsoverthecounter.com/# fluconazole over the counter

humana over the counter male enhancement pills over the counter

https://over-the-counter-drug.com/# bronchial inhalers over the counter

over the counter antibiotic over the counter viagra substitute

https://over-the-counter-drug.com/# over the counter pink eye medicine

over the counter pills like viagra best sleep aid over the counter

best over the counter sleep aid over the counter essentials united healthcare

https://over-the-counter-drug.com/# over the counter acne treatments

over the counter medicine for strep throat over the counter anti nausea medication

IG s are very timid stromectol info It was heading for the city of Limoges in west central France

best over the counter diet pills over the counter essentials united healthcare

over the counter tapeworm treatment for dogs over the counter appetite suppressant

https://over-the-counter-drug.com/# humana over the counter

over the counter pain medication over the counter health and wellness products

over the counter pink eye medicine over the counter weight loss pills

over the counter weight loss pills over the counter pill for yeast infection

over the counter inhalers walgreens sleep aids over the counter

where can i buy amoxicillin online order amoxil

https://stromectol.science/# ivermectin cost canada

buy zithromax online zithromax 250 mg tablet price

doxycycline order online doxycycline 50mg or order doxycycline online

http://canoefunds.net/__media__/js/netsoltrademark.php?d=over-the-counter-drug.com doxycycline generic

buy doxycycline without prescription uk where to get doxycycline and doxycycline prices doxycycline 100mg dogs

zithromax 500mg price buy zithromax

https://stromectol.science/# minocycline 50 mg tablets online

generic doxycycline 200 mg doxycycline

https://doxycycline.science/# doxycycline hyc

zithromax for sale buy cheap generic zithromax

zithromax online pharmacy canada zithromax

https://doxycycline.science/# doxycycline 150 mg

ivermectin 0.5 lotion india ivermectin gel

ivermectin minocycline for acne or stromectol buy uk

http://stevemartinonline.com/__media__/js/netsoltrademark.php?d=stromectol.science ivermectin 6mg

ivermectin 18mg buy ivermectin pills and minocycline capsulas ivermectin for humans

zithromax capsules 250mg generic zithromax

https://doxycycline.science/# doxycycline 50 mg

cheap zithromax zithromax 500mg price

https://stromectol.science/# minocycline for rosacea

cheap stromectol ivermectin 10 mg

amoxicillin 250 mg amoxicillin online purchase or amoxicillin buy online canada

http://hearing-aids-richmond-in.com/__media__/js/netsoltrademark.php?d=amoxil.science amoxicillin 500mg without prescription

generic amoxil 500 mg amoxicillin 250 mg and how to get amoxicillin can i buy amoxicillin over the counter

doxycycline hyc doxycycline 100mg tablets

https://zithromax.science/# zithromax online no prescription

doxycycline 100mg price odering doxycycline

https://doxycycline.science/# where to purchase doxycycline

ivermectin medication stromectol for sale

https://amoxil.science/# amoxicillin medicine over the counter

generic stromectol minocycline antibiotic

can i buy zithromax online where can i buy zithromax medicine or zithromax z-pak

http://fitzgeraldsbh.com/__media__/js/netsoltrademark.php?d=zithromax.science zithromax

zithromax capsules price buy zithromax canada and zithromax prescription in canada generic zithromax over the counter

https://doxycycline.science/# doxycycline 500mg

stromectol minocycline 50 mg tabs

doxycycline 100mg capsules buy doxycycline online 270 tabs or buy doxycycline monohydrate

http://franchisethoughtleaders.com/__media__/js/netsoltrademark.php?d=doxycycline.science how to buy doxycycline online

order doxycycline doxycycline 150 mg and where can i get doxycycline doxycycline 200 mg

zithromax capsules buy zithromax online

https://stromectol.science/# minocycline 100 mg pills

cheap zithromax zithromax z-pak price without insurance

minocycline 100mg tablets ivermectin iv or minocycline 100 mg capsule

http://ww3.augustadieteticintern.org/__media__/js/netsoltrademark.php?d=stromectol.science stromectol covid 19

buy stromectol canada generic ivermectin for humans and ivermectin tablets uk minocycline interactions

amoxicillin where to get amoxil

https://zithromax.science/# zithromax prescription online

buy stromectol buy ivermectin

https://amoxil.science/# amoxicillin 500 mg online

cheap stromectol minocycline mr

Definitive journal of drugs and therapeutics. Cautions.

ivermectin 1% cream generic

Generic Name. Get information now.

Best and news about drug. Read information now.

stromectol where to buy

All trends of medicament. Generic Name.

Some are medicines that help people when doctors prescribe. Best and news about drug.

stromectol for humans

Commonly Used Drugs Charts. Commonly Used Drugs Charts.

Commonly Used Drugs Charts. Long-Term Effects.

ivermectin lotion for lice

Top 100 Searched Drugs. Get here.

Prescription Drug Information, Interactions & Side. Get warning information here.

https://stromectolst.com/# stromectol over the counter

Read here. Read here.

ivermectin coronavirus cost of stromectol medication or ivermectin 10 mg

http://tairfinternational.org/__media__/js/netsoltrademark.php?d=stromectolst.com stromectol in canada

stromectol ireland stromectol 3 mg dosage and ivermectin 10 mg ivermectin humans

Everything what you want to know about pills. Read information now.

https://stromectolst.com/# ivermectin humans

Top 100 Searched Drugs. drug information and news for professionals and consumers.

buy ivermectin nz ivermectin 3 mg or buy stromectol canada

http://peninhand.com/__media__/js/netsoltrademark.php?d=stromectolst.com ivermectin 1 cream

cost of ivermectin cream stromectol 6 mg dosage and ivermectin syrup ivermectin eye drops

Drugs information sheet. Everything information about medication.

cost of ivermectin pill

earch our drug database. Everything information about medication.

Poster Viewing Session III Saturday, September 11, 2021 6 55 PM 7 05 PM Exhibit Hall ePoster Hub Monitor 24 lasix and hyponatremia

minocycline pac minocycline 100 mg without a doctor or ivermectin 50mg/ml

http://pegit.us/__media__/js/netsoltrademark.php?d=stromectol.science stromectol tablets for humans

purchase stromectol minocycline capsule and generic ivermectin cream ivermectin 200mg

Some are medicines that help people when doctors prescribe. drug information and news for professionals and consumers.

ivermectin 1 cream generic

All trends of medicament. Definitive journal of drugs and therapeutics.

Long-Term Effects. Read here.

https://stromectolst.com/# ivermectin generic cream

Generic Name. Generic Name.

minocycline acne stromectol price us or ivermectin 1 cream generic

http://ddyearbook.com/__media__/js/netsoltrademark.php?d=stromectol.science stromectol how much it cost

ivermectin 10 ml ivermectin 1 and ivermectin 3 mg price of ivermectin tablets

ivermectin 18mg stromectol coronavirus or ivermectin cost

http://insightoftheweek.com/__media__/js/netsoltrademark.php?d=stromectolst.com stromectol 3mg cost

ivermectin purchase ivermectin tablets and ivermectin generic cream п»їorder stromectol online

where to buy ivermectin pills stromectol tablet 3 mg or where to buy stromectol

http://executivebeechcraft.com/__media__/js/netsoltrademark.php?d=stromectolst.com ivermectin new zealand

stromectol 3 mg price ivermectin drug and stromectol covid ivermectin gel

Get information now. Long-Term Effects.

https://stromectolst.com/# cost of ivermectin medicine

Read here. Read here.

buy minocycline 50 mg for humans minocycline 50mg tablets online or minocycline 100 mg online

http://park-10.com/__media__/js/netsoltrademark.php?d=stromectol.science buy ivermectin cream

ivermectin lice ivermectin tablet price and minocycline uses topical ivermectin cost

All trends of medicament. drug information and news for professionals and consumers.

ivermectin pills human

What side effects can this medication cause? Some are medicines that help people when doctors prescribe.

Best and news about drug. Some trends of drugs.

lisinopril 20 mg buy

Definitive journal of drugs and therapeutics. Get here.

Drugs information sheet. Commonly Used Drugs Charts. where can i buy generic avodart price

What side effects can this medication cause? Learn about the side effects, dosages, and interactions.

Some are medicines that help people when doctors prescribe. Drug information.

how much is lisinopril

Read here. Definitive journal of drugs and therapeutics.

Long-Term Effects. Cautions.

https://lisinopril.science/# lisinopril 3760

Read here. Some are medicines that help people when doctors prescribe.

Medscape Drugs & Diseases. Cautions.

https://levaquin.science/# can i order levaquin without insurance

Learn about the side effects, dosages, and interactions. Drug information.

mobic medication where buy mobic without a prescription or can you get generic mobic pills

http://azcatholic.com/__media__/js/netsoltrademark.php?d=mobic.store can i order generic mobic

can i buy cheap mobic without rx how can i get mobic without a prescription and how can i get mobic online can you get generic mobic price

п»їMedicament prescribing information. Actual trends of drug.

online lisinopril

Medscape Drugs & Diseases. Everything information about medication.

Prescription Drug Information, Interactions & Side. safe and effective drugs are available.

where can i buy nexium pills

Generic Name. safe and effective drugs are available.

Get here. Medscape Drugs & Diseases.

https://mobic.store/# can i get mobic

Actual trends of drug. safe and effective drugs are available.

where to get cheap levaquin without a prescription where buy levaquin tablets or can i buy cheap levaquin without insurance

http://realfresh.info/__media__/js/netsoltrademark.php?d=levaquin.science where to get cheap levaquin price

cost levaquin pill buy levaquin for sale and get generic levaquin without insurance can you buy levaquin pills

earch our drug database. Generic Name.

https://lisinopril.science/# medication zestoretic

Read information now. safe and effective drugs are available.

generic avodart without rx order avodart without insurance or can i get cheap avodart without rx

http://meigroup.info/__media__/js/netsoltrademark.php?d=avodart.science can you get avodart online

cheap avodart price order avodart and can i buy cheap avodart without dr prescription how can i get generic avodart

Learn about the side effects, dosages, and interactions. Commonly Used Drugs Charts.

how can i get nexium no prescription

Best and news about drug. Read information now.

Read information now. Some are medicines that help people when doctors prescribe.

can you buy generic nexium pill

Prescription Drug Information, Interactions & Side. Learn about the side effects, dosages, and interactions.

п»їMedicament prescribing information. Get here.

https://levaquin.science/# how can i get cheap levaquin for sale

Get here. Learn about the side effects, dosages, and interactions.

Everything information about medication. Drugs information sheet.

where to get nexium no prescription

Everything information about medication. Best and news about drug.

how to buy generic nexium cost cheap nexium without rx or where to buy cheap nexium pill

http://quickmedlabonline.com/__media__/js/netsoltrademark.php?d=nexium.top can i get nexium pills

nexium generics cost of cheap nexium without dr prescription and can i buy cheap nexium for sale cost of nexium tablets

Cautions. Get information now.

where can i buy cheap clomid online

Cautions. Drug information.

safe and effective drugs are available. Medicament prescribing information. amoxicillin generic

Read now. Prescription Drug Information, Interactions & Side.

Everything what you want to know about pills. Get information now.

can i purchase generic propecia no prescription

All trends of medicament. drug information and news for professionals and consumers.

Top 100 Searched Drugs. What side effects can this medication cause?

cost generic clomid pills

Actual trends of drug. Get here.

Get here. Drug information. https://amoxicillins.com/ can i buy amoxicillin over the counter

Get information now. safe and effective drugs are available.

amoxicillin no prescipion amoxicillin buy no prescription or buy amoxicillin online with paypal

http://catdoctor.info/__media__/js/netsoltrademark.php?d=amoxicillins.online can i buy amoxicillin online

amoxicillin 50 mg tablets amoxicillin 500mg pill and amoxicillin 500mg without prescription amoxicillin 500mg cost

Top 100 Searched Drugs. Actual trends of drug. amoxicillin 250 mg

Definitive journal of drugs and therapeutics. Read now.

Comprehensive side effect and adverse reaction information. Cautions.

can i order generic clomid without rx

Definitive journal of drugs and therapeutics. Read information now.

can you buy clomid now how to buy generic clomid without prescription or where buy clomid no prescription

http://ratehealthinsurance.com/__media__/js/netsoltrademark.php?d=clomiphenes.online get cheap clomid online

where to buy cheap clomid tablets where can i get clomid prices and order cheap clomid pills where to get clomid without dr prescription

All trends of medicament. Cautions. https://amoxicillins.com/ amoxicillin capsule 500mg price

Everything information about medication. Generic Name.

zithromax 1000 mg online where to get zithromax over the counter or zithromax online usa

http://conversion-calculator.com/__media__/js/netsoltrademark.php?d=azithromycins.online zithromax price south africa

zithromax antibiotic where can i purchase zithromax online and zithromax cost australia zithromax 250

What side effects can this medication cause? Some trends of drugs. https://amoxicillins.com/ where can you buy amoxicillin over the counter

All trends of medicament. Drug information.

Everything what you want to know about pills. Best and news about drug.

clomid rx

Long-Term Effects. Generic Name.

Drugs information sheet. Some trends of drugs.

where can i buy propecia no prescription

Some trends of drugs. Read now.

how to buy cheap propecia for sale can you buy propecia without a prescription or where can i buy propecia without dr prescription

http://www.virusfm.ru/go.php?url=https://finasteridest.online buy generic propecia prices

can i order generic propecia for sale order generic propecia and where to buy propecia can i purchase generic propecia now

buy amoxicillin 500mg generic amoxicillin cost or amoxicillin 500 mg without prescription

http://borrowing.info/__media__/js/netsoltrademark.php?d=amoxicillins.online amoxicillin 500 capsule

amoxicillin 500mg capsules uk amoxicillin in india and where can you get amoxicillin can i purchase amoxicillin online

Medscape Drugs & Diseases. Comprehensive side effect and adverse reaction information.

get cheap propecia no prescription

Everything what you want to know about pills. Get information now.

Some are medicines that help people when doctors prescribe. Get here.

buying clomid pills

Definitive journal of drugs and therapeutics. Read information now.

Read information now. Drug information.

cost clomid price

drug information and news for professionals and consumers. Medscape Drugs & Diseases.

Definitive journal of drugs and therapeutics. Get information now.

zithromax cost australia

Get information now. Read information now.

where can i buy clomid without a prescription can i purchase clomid without prescription or can i purchase generic clomid without dr prescription

http://www.2-rabbits.com/__media__/js/netsoltrademark.php?d=clomiphenes.online how can i get generic clomid

where to buy generic clomid now how to buy generic clomid no prescription and can you buy generic clomid how to buy cheap clomid online

Read information now. safe and effective drugs are available.

where to buy propecia for sale

Commonly Used Drugs Charts. Get warning information here.

Get warning information here. Read information now.

erectile dysfunction drug

Top 100 Searched Drugs. What side effects can this medication cause?

Long-Term Effects. Some are medicines that help people when doctors prescribe.

how to cure ed

Comprehensive side effect and adverse reaction information. Everything what you want to know about pills.

Cautions. What side effects can this medication cause?

best pills for ed

Everything information about medication. Medicament prescribing information.

Cautions. Actual trends of drug.

https://edonlinefast.com best ed medications

Actual trends of drug. Read now.

drug information and news for professionals and consumers. Get here.

ed pills online

What side effects can this medication cause? safe and effective drugs are available.

Cautions. Actual trends of drug.

https://edonlinefast.com pills for erection

Read information now. Everything about medicine.

All trends of medicament. Get warning information here.

where can i buy clomid pills

Drug information. safe and effective drugs are available.

generic ed drugs buy erection pills or non prescription ed drugs

http://laborfactory.com/__media__/js/netsoltrademark.php?d=edonlinefast.com ed remedies

best male enhancement pills best ed treatment pills and ed treatments ed pills for sale

Read now. Everything what you want to know about pills.

over the counter erectile dysfunction pills

Top 100 Searched Drugs. All trends of medicament.

ed drugs ed pills comparison or how to cure ed

http://learnaztec.com/__media__/js/netsoltrademark.php?d=edonlinefast.com male ed drugs

ed dysfunction treatment male erection pills and mens erection pills drugs for ed

Get information now. What side effects can this medication cause?

best erectile dysfunction pills

Read now. What side effects can this medication cause?

Learn about the side effects, dosages, and interactions. Long-Term Effects.

best online canadian pharmacy

Everything information about medication. Generic Name.

Drugs information sheet. Definitive journal of drugs and therapeutics.

carprofen without vet prescription

Learn about the side effects, dosages, and interactions. What side effects can this medication cause?

Best and news about drug. drug information and news for professionals and consumers.

https://canadianfast.online/# carprofen without vet prescription

Read information now. Learn about the side effects, dosages, and interactions.

Some trends of drugs. earch our drug database.

amoxicillin without a doctor's prescription

safe and effective drugs are available. Read information now.

escrow pharmacy canada legit canadian pharmacy or canadian pharmacy sildenafil

http://unmutualbank.mobi/__media__/js/netsoltrademark.php?d=canadianfast.online canadian pharmacy

canadian pharmacy prices pharmacy in canada for viagra and canadian pharmacy india canada drugstore pharmacy rx

canadian drugstore online ed drugs online from canada or cvs prescription prices without insurance

http://bq--3bjqlcg5njpwrma.org/__media__/js/netsoltrademark.php?d=canadianfast.com buy prescription drugs from canada cheap

ed meds online without prescription or membership dog antibiotics without vet prescription and best ed pills non prescription buy prescription drugs without doctor

Top 100 Searched Drugs. Read here.

ed meds online without doctor prescription

Read now. Learn about the side effects, dosages, and interactions.

livial ofloxacin ornidazole tablets ip uses in tamil In 1996, the act was amended to expressly prohibit marriage for same sex couples, according to the lawsuit cialis tablets for sale The suppressive effect of cortisol on the apoptotic ability and DNA repair capacity of cells, as well as its negative effect on immunity, suggests that a connection between stress signaling and tumor development is biologically plausible

Commonly Used Drugs Charts. Read now.

canadian drugs pharmacy

п»їMedicament prescribing information. п»їMedicament prescribing information.

drug information and news for professionals and consumers. earch our drug database.

https://canadianfast.online/# carprofen without vet prescription

Some trends of drugs. Read information now.

All trends of medicament. safe and effective drugs are available.

https://canadianfast.com/# non prescription ed pills

Drugs information sheet. Comprehensive side effect and adverse reaction information.

Top 100 Searched Drugs. Everything information about medication.

ed meds online without doctor prescription

Best and news about drug. Comprehensive side effect and adverse reaction information.

Read now. safe and effective drugs are available.

canadian pharmacy viagra 100mg

Actual trends of drug. Some trends of drugs.

Everything about medicine. Get here.

https://canadianfast.com/# best non prescription ed pills

Get information now. Top 100 Searched Drugs.

What side effects can this medication cause? drug information and news for professionals and consumers.

https://canadianfast.online/# ed meds online without prescription or membership

Learn about the side effects, dosages, and interactions. Prescription Drug Information, Interactions & Side.

pharmacies in canada that ship to the us canadian pharmacies compare or canadian pharmacy

http://intellishop.org/__media__/js/netsoltrademark.php?d=canadianfast.online northern pharmacy canada

pharmacy in canada for viagra canadian pharmacy and canadian pharmacy meds review viagra canadian pharmacy

What side effects can this medication cause? Drugs information sheet.

how to get prescription drugs without doctor

What side effects can this medication cause? Read information now.

safe and effective drugs are available. Read here.

pharmacy rx world canada

Everything what you want to know about pills. Learn about the side effects, dosages, and interactions.

Everything about medicine. Generic Name.

https://viagrapillsild.com/# where i can buy viagra in australia

Long-Term Effects. Get information now.

Some are medicines that help people when doctors prescribe. earch our drug database.

buy sildenafil india online

All trends of medicament. Everything about medicine.

Read here. Top 100 Searched Drugs.

sildenafil mexico online

Generic Name. Prescription Drug Information, Interactions & Side.

Read now. Drug information.

viagra u.s.a

Best and news about drug. Read information now.

delhi, india viagra generic viagra pills or trial pack viagra levitra

http://atlasvanlinessf.com/__media__/js/netsoltrademark.php?d=viagrapillsild.online cheapest viagra australia

what i viagra for women looking to purchase generic viagra and buy brand viagra online top viagra store

Cautions. safe and effective drugs are available.

order viagra online canada

Long-Term Effects. Everything what you want to know about pills.

Drugs information sheet. What side effects can this medication cause?

sildenafil products

Cautions. Actual trends of drug.

Get here. All trends of medicament.

viagra for women reviews

Get information now. Definitive journal of drugs and therapeutics.

Learn about the side effects, dosages, and interactions. Read here.

tadalafil 5mg tablets price

Medscape Drugs & Diseases. Get warning information here.

Get warning information here. Read information now.

cialis 20mg usa

Everything what you want to know about pills. Get warning information here.

Prescription Drug Information, Interactions & Side. Long-Term Effects.

cialis wikipedia

drug information and news for professionals and consumers. Definitive journal of drugs and therapeutics.

free samples for cialis black cialis or san antonio cialis doctor

http://luxury-events.com/__media__/js/netsoltrademark.php?d=tadalafil1st.online google south africa cialis

generic cialis available in usa cialis where to buy in las vegas nv and buy generic cialis online overnight purchase cialis online

Long-Term Effects. Read information now.

cialis professional india

Cautions. What side effects can this medication cause?

Get here. Commonly Used Drugs Charts.

black cialis

Some are medicines that help people when doctors prescribe. Read information now.

bph cialis dosage cialis online america or cialis professional ingredients

http://utsteintemplate.com/__media__/js/netsoltrademark.php?d=tadalafil1st.online cialis reviews patients

free cialis online online cialis florida delivery and best price cialis supper active supreme suppliers cialis

earch our drug database. Medscape Drugs & Diseases.

https://tadalafil1st.online/# tadalafil 30

Best and news about drug. Some are medicines that help people when doctors prescribe.

All trends of medicament. Drugs information sheet.

where can i buy cialis in singapore

Some are medicines that help people when doctors prescribe. Read here.

cheap cialis online generic online cialis florida delivery or cialis tablets in australia

http://toppros.org/__media__/js/netsoltrademark.php?d=tadalafil1st.com cialis from usa

buy cialis using paypal low cost cialis and generic cialis? generic cialis without prescription

п»їMedicament prescribing information. Drug information.

purchase cialis with paypal

Learn about the side effects, dosages, and interactions. Learn about the side effects, dosages, and interactions.

earch our drug database. Read here.

generic of cialis

Top 100 Searched Drugs. Best and news about drug.

Some are medicines that help people when doctors prescribe. Long-Term Effects.

https://tadalafil1st.online/# generic tadalafil united states

Learn about the side effects, dosages, and interactions. Drug information.

generic cialis no prescription cialis with daxopretine or use paypal to buy cialis

http://gogobana.com/__media__/js/netsoltrademark.php?d=tadalafil1st.online cialis professional india

whats better cialis or viagra costco cialis and cialis blaack cialis online american express

п»їMedicament prescribing information. Read information now.

cialis tadalafil

Some trends of drugs. Everything about medicine.

earch our drug database. Long-Term Effects.

tadalafil in india online

Everything information about medication. earch our drug database.

Prescription Drug Information, Interactions & Side. drug information and news for professionals and consumers.

non prescription prednisone 20mg

amoxicillin 500 mg tablets

What side effects can this medication cause? Some trends of drugs.

Generic Name. Prescription Drug Information, Interactions & Side.

clomid sale

buy generic clomid pill

how much is amoxicillin prescription

Read here. Read information now.

Some trends of drugs. Everything what you want to know about pills.

propecia pills

https://zithromaxa.fun/ zithromax coupon

buy clomid without prescription

Some are medicines that help people when doctors prescribe. Learn about the side effects, dosages, and interactions.

amoxicillin 500mg tablets price in india buy amoxicillin online uk or buy amoxicillin 500mg capsules uk

http://chimneysrus.com/__media__/js/netsoltrademark.php?d=amoxila.store amoxicillin over the counter in canada

amoxicillin brand name amoxicillin 875 125 mg tab and amoxicillin discount amoxacillian without a percription

safe and effective drugs are available. Best and news about drug.

zithromax pill

zithromax online australia

Top 100 Searched Drugs. Cautions.

Read here. Comprehensive side effect and adverse reaction information.

can i get generic propecia without dr prescription

Drugs information sheet. Read information now.

cost cheap propecia without prescription propecia or how to buy cheap propecia without dr prescription

http://resolvit-resources.com/__media__/js/netsoltrademark.php?d=propeciaf.store buying propecia no prescription

buying generic propecia pill buy propecia price and how to get propecia tablets cost propecia without prescription

п»їMedicament prescribing information. Some trends of drugs.

propecia cheap

amoxicillin 500 mg tablet

cheap generic prednisone

earch our drug database. drug information and news for professionals and consumers.

cost of generic zithromax zithromax azithromycin or how to buy zithromax online

http://facecard.biz/__media__/js/netsoltrademark.php?d=zithromaxa.fun how to get zithromax online

where to buy zithromax in canada zithromax 1000 mg pills and zithromax 500 mg lowest price online zithromax over the counter canada

cost clomid price can you get cheap clomid no prescription or get generic clomid without dr prescription

http://realcoinfraud.com/__media__/js/netsoltrademark.php?d=clomidc.fun buying generic clomid without insurance

clomid otc buying cheap clomid online and get generic clomid can i purchase cheap clomid without rx

п»їMedicament prescribing information. Prescription Drug Information, Interactions & Side.

can you buy zithromax over the counter in australia

how to buy propecia without dr prescription

Everything information about medication. Definitive journal of drugs and therapeutics.

Read information now. Medicament prescribing information.

https://zithromaxa.fun/ zithromax purchase online

buy zithromax canada

Medscape Drugs & Diseases. safe and effective drugs are available.

Cautions. Prescription Drug Information, Interactions & Side.

buy zithromax no prescription

https://propeciaf.store/ generic propecia without insurance

https://amoxila.store/ order amoxicillin 500mg

Drug information. Some are medicines that help people when doctors prescribe.

Drugs information sheet. All trends of medicament.

prednisone 60 mg daily

Learn about the side effects, dosages, and interactions. earch our drug database.

Some trends of drugs. Get information now.

prednisone 20 tablet

generic zithromax online paypal

Cautions. Medscape Drugs & Diseases.

where to buy propecia prices can i purchase propecia without a prescription or order cheap propecia prices

http://ginc.info/__media__/js/netsoltrademark.php?d=propeciaf.store get cheap propecia pill

how to get cheap propecia without rx how can i get propecia online and propecia pills where buy generic propecia pills

п»їMedicament prescribing information. Get information now.

buy prednisone online canada

amoxicillin 500 coupon

Top 100 Searched Drugs. Medscape Drugs & Diseases.

Everything what you want to know about pills. Drug information.

cost generic propecia without insurance

https://propeciaf.store/ get propecia without dr prescription

generic propecia pills

Drugs information sheet. Cautions.

generic clomid without rx can you get clomid tablets or how can i get cheap clomid without insurance

http://www.any-hair.jp/cgi-bin/m/index.cgi?id=28&mode=redirect&ref_eid=527&url=https://clomidc.fun how can i get clomid without insurance

cost of cheap clomid pill cheap clomid for sale and order generic clomid tablets where can i get cheap clomid

Drug information. Medicament prescribing information.

https://prednisoned.top/ prednisone 20mg for sale

how to buy clomid price

Everything what you want to know about pills. Get information now.

purchase zithromax z-pak buy zithromax online australia or zithromax 500 mg lowest price drugstore online

http://mcdonaldcountyfair.com/__media__/js/netsoltrademark.php?d=zithromaxa.fun zithromax cost uk

zithromax 500mg price zithromax 250mg and cheap zithromax pills zithromax 500mg price

generic amoxicillin cost amoxicillin capsules 250mg or amoxicillin online without prescription

http://northstartravelnetworks.com/__media__/js/netsoltrademark.php?d=amoxila.store amoxicillin for sale

amoxicillin tablet 500mg buy amoxicillin 500mg capsules uk and amoxicillin 1000 mg capsule where to buy amoxicillin over the counter

drug information and news for professionals and consumers. Read information now.

purchase amoxicillin 500 mg

prednisone 10mg tablet cost

Medicament prescribing information. Medicament prescribing information.

drug information and news for professionals and consumers. Everything what you want to know about pills.

can i get clomid without prescription

buy generic prednisone online

Actual trends of drug. Comprehensive side effect and adverse reaction information.

where can i buy propecia for sale how can i get generic propecia price or cost of cheap propecia

http://totaltrainerfactoryoutlet.com/__media__/js/netsoltrademark.php?d=propeciaf.store how to buy generic propecia prices

buy propecia price where buy generic propecia tablets and cheap propecia without insurance generic propecia prices

Get here. Medscape Drugs & Diseases.

cost of cheap clomid

buy cheap zithromax online

https://zithromaxa.fun/ zithromax price canada

Drugs information sheet. Long-Term Effects.

indian pharmacies safe order viagra india online

https://torrent-zona.3dn.ru/go?https://indiaph.pro best online pharmacy india

buy prescription drugs from india cheapest cialis from india

canadianpharmacymeds best canadian online pharmacy reviews

http://www.oktayustam.com/site/yonlendir.aspx?URL=https://canadaph.top canadian pharmacy 24h com

canadian pharmacy viagra onlinecanadianpharmacy 24

reputable mexican pharmacies online: mexican pharmacy online - mexican pharmaceuticals online

http://canadaph.top/# canadian pharmacy 24 com

mexican drugstore online mexican pharmacy online mexican drugstore online

canadadrugpharmacy com: mexican pharmacy online - canadian pharmacy meds review

http://mexicanpharmacy.pro/# pharmacies in mexico that ship to usa

mexican border pharmacies shipping to usa mexican pharmacy online buying from online mexican pharmacy

canadian pharmacy antibiotics: us online pharmacy - viagra online canadian pharmacy

http://mexicanpharmacy.pro/# mexican online pharmacies prescription drugs

legit canadian online pharmacy overseas pharmacies shipping to usa canadian drug

purple pharmacy mexico price list: purple pharmacy mexico price list - mexican mail order pharmacies

https://canadaph.top/# best canadian pharmacy for cialis

pharmacies in mexico that ship to usa mexican mail order pharmacies purple pharmacy mexico price list

mexico drug stores pharmacies: mexican pharmacy online - mexican rx online

https://mexicanpharmacy.pro/# buying prescription drugs in mexico online

canadian pharmacy us online pharmacy canadian discount pharmacy

best canadian online pharmacy: buy prescription drugs from canada cheap - canadian pharmacy online ship to usa

http://mexicanpharmacy.pro/# medicine in mexico pharmacies

reputable canadian pharmacy mexican pharmacy online buy canadian drugs

buy cialis generic india cheap viagra india

https://wfc2.wiredforchange.com/dia/track.jsp?v=2&c=hdorrh+HcDlQ+zUEnZU5qlfKZ1Cl53X6&url=https://indiapills.pro reputable indian online pharmacy

viagra online order india mail order pharmacy india

best erection pills buy ed pills

http://hamov.com/redirect.asp?url=https://edpills.men best pills for ed

ed drugs list cheap ed drugs

best canadian online pharmacy reviews safe reliable canadian pharmacy

http://truehits.net/webout.php?url=https://canadadrugs.best reddit canadian pharmacy

certified canadian international pharmacy best rated canadian pharmacy

canadapharmacyonline: mexican pharmacy online - viagra from canadian pharmacy

http://canadadrugs.best/# canadian pharmacy ratings

canadian pharmacy cheap prescription drugs canada buy online best canadian pharmacy online

generic cialis india buy cialis from india

http://buryatia.ru/cgi-bin/redirect.cgi?url=indiapills.pro cheap viagra online india

buy cialis generic india indian pharmacy

pills for erection ed medications online

http://www.maxmailing.be/tl.php?p=32x/rs/rs/rv/sd/rt//https://edpills.men the best ed pills

cheap erectile dysfunction pills cheap ed pills

canadian pharmacy 365 canada pharmacy 24h

http://www.kiwiprint.co.nz/ra.asp?url=https://canadadrugs.best vipps approved canadian online pharmacy

canadian pharmacies canadian online drugs

viagra from india: world pharmacy india - cialis pills india

https://edpills.men/# best pills for ed

best canadian pharmacy overseas pharmacies shipping to usa canada drugs online review

generic ed pills: buy erection pills - best drug for ed

http://edpills.men/# best erection pills

pills for erection buy erection pills ed drugs

reliable canadian pharmacy: canadian online pharmacy no prescription - canada pharmacy online

http://canadadrugs.best/# legit canadian online pharmacy

canadian pharmacy price checker overseas pharmacies shipping to usa canadian pharmacy price checker

ed treatment review: buy erection pills - cheap erectile dysfunction pills online

https://canadadrugs.best/# buying from canadian pharmacies

new ed treatments best over the counter ed pills cheapest ed pills

viagra online buy india cheap generic levitra india

http://wfc2.wiredforchange.com/dia/track.jsp?key=-1&url_num=19&url=https://indiapills.pro generic viagra cheap india

how to order viagra in india online pharmacy india

new ed pills: cheap erectile dysfunction pills online - ed medication online

http://edpills.men/# erectile dysfunction drug

indian pharmacies safe india pharmacy without dr prescriptions how to buy viagra in india

canadian pharmacy 24 canadian pharmacy viagra 50 mg

https://wdesk.ru/go?https://canadadrugs.best/ canadian pharmacy viagra reviews

canadian pharmacy drugs online canadian pharmacy com

online canadian pharmacy: mexican pharmacy online - canada ed drugs

https://canadadrugs.best/# canadadrugpharmacy com

gnc ed pills pills for ed impotence pills

canadian world pharmacy: overseas pharmacies shipping to usa - canadian pharmacies that deliver to the us

http://edpills.men/# best male ed pills

online canadian pharmacy us online pharmacy canada ed drugs

canadian drugstore online: best rated canadian pharmacy - cheapest pharmacy canada

https://mexicanph.best/# medicine in mexico pharmacies

canadian pharmacy king canada pharmacy world cheap canadian pharmacy online

canada drugs online review: canadian pharmacies - canadian pharmacy ltd

http://mexicanph.best/# buying prescription drugs in mexico online

cheap generic viagra india best online international pharmacies india cheap cialis india

order viagra online india: best online international pharmacies india - cheap viagra india

http://mexicanph.best/# buying prescription drugs in mexico

best online pharmacies in mexico mexican mail order pharmacies buying from online mexican pharmacy

mexican online pharmacies prescription drugs: buying from online mexican pharmacy - mexican online pharmacies prescription drugs

https://mexicanph.best/# buying prescription drugs in mexico

how to order viagra in india best online international pharmacies india indianpharmacy com

mexican drugstore online: medicine in mexico pharmacies - buying from online mexican pharmacy

https://canadianph.pro/# canadian pharmacy near me

top 10 online pharmacy in india india pharmacy canadian pharmacy india

viagra online order india: india pharmacy without dr prescriptions - cheap generic viagra india

https://indiaph.store/# india pharmacy mail order

п»їbest mexican online pharmacies mexican border pharmacies shipping to usa mexico pharmacies prescription drugs

canadian compounding pharmacy canadianpharmacymeds or best canadian pharmacy online

http://15minuteretirementplan.com/__media__/js/netsoltrademark.php?d=canadianph.pro legitimate canadian online pharmacies

legit canadian pharmacy safe canadian pharmacies and online pharmacy canada escrow pharmacy canada

certified canadian international pharmacy: canadian pharmacy com - canadian drug stores

https://mexicanph.best/# best online pharmacies in mexico

generic viagra cheap india rx pharmacy india online pharmacy india

indian pharmacy paypal buy prescription drugs from india or order cialis india

http://yoga-sandal.net/__media__/js/netsoltrademark.php?d=indiaph.store buy cialis in india

india online pharmacy cialis pills from india and cheap viagra from india reputable indian online pharmacy

canadian drug: canadian pharmacy cialis 40 mg - canadianpharmacyworld com

https://canadianph.pro/# my canadian pharmacy reviews

п»їbest mexican online pharmacies mexican rx online buying prescription drugs in mexico

ed doctors ed meds online canada homeopathic remedies for ed

cheap medications: levitra without a doctor prescription - comfortis for dogs without vet prescription

best ed pill: reasons for ed - canadian drugs

treatment for erectile dysfunction ed meds pills drugs cheap ed medication

ed meds online without doctor prescription canadian medications cheap medication online

ed problems treatment: what is the best ed drug - comfortis for dogs without vet prescription

Viagra Tabletten: Viagra kaufen gГјnstig Deutschland - Viagra Г–sterreich rezeptfrei Apotheke

SildГ©nafil 100 mg prix en pharmacie en France: Viagra homme prix en pharmacie - Viagra femme ou trouver

viagra online cerca de zaragoza: comprar viagra en espaГ±a amazon - comprar sildenafilo cinfa 100 mg espaГ±a

viagra cosa serve: viagra generico prezzo piГ№ basso - pillole per erezione immediata

Viagra diskret bestellen: Viagra Preis Schwarzmarkt - Viagra rezeptfreie Schweiz bestellen

п»їViagra sans ordonnance 24h: Viagra homme prix en pharmacie sans ordonnance - Viagra sans ordonnance livraison 24h

comprar viagra sin gastos de envГo: se puede comprar sildenafil sin receta - comprar viagra sin gastos de envГo

farmacia senza ricetta recensioni: viagra naturale in farmacia senza ricetta - cerco viagra a buon prezzo

Viagra Pfizer sans ordonnance: Viagra gГ©nГ©rique sans ordonnance en pharmacie - Viagra 100mg prix

Viagra kaufen gГјnstig Deutschland Viagra Preis Schwarzmarkt or Viagra rezeptfreie bestellen

http://www.fashionenira.com/__media__/js/netsoltrademark.php?d=viagermany.pro п»їViagra kaufen

Viagra kaufen ohne Rezept legal Viagra kaufen gГјnstig Deutschland and Billig Viagra bestellen ohne Rezept Viagra Apotheke rezeptpflichtig

comprar viagra sin gastos de envГo: sildenafilo cinfa precio - sildenafilo cinfa 100 mg precio farmacia

venta de viagra a domicilio: sildenafilo 100mg farmacia - sildenafilo cinfa 100 mg precio farmacia

SildГ©nafil Teva 100 mg acheter: Prix du Viagra 100mg en France - Viagra pas cher paris

SildГ©nafil 100 mg sans ordonnance Viagra sans ordonnance 24h suisse or Meilleur Viagra sans ordonnance 24h

http://janetandjonathan.com/__media__/js/netsoltrademark.php?d=viafrance.store Viagra vente libre pays

Viagra pas cher livraison rapide france Meilleur Viagra sans ordonnance 24h and Viagra homme prix en pharmacie sans ordonnance Viagra vente libre pays

Viagra kaufen gГјnstig: Viagra Preis Schwarzmarkt - Sildenafil kaufen online

Viagra diskret bestellen Viagra Alternative rezeptfrei or Viagra online kaufen legal in Deutschland

http://therecoveryplace.org/__media__/js/netsoltrademark.php?d=viagermany.pro Viagra diskret bestellen

Viagra kaufen ohne Rezept Schweiz Generika Potenzmittel rezeptfrei online kaufen and Viagra Generika online kaufen ohne Rezept Sildenafil Preis

comprar viagra en espaГ±a: sildenafilo 100mg precio farmacia - se puede comprar viagra sin receta

comprar viagra en espaГ±a: comprar sildenafilo cinfa 100 mg espaГ±a - viagra online cerca de zaragoza

Viagra pas cher livraison rapide france Sildenafil teva 100 mg sans ordonnance or Viagra homme sans ordonnance belgique

http://kellercapital.com/__media__/js/netsoltrademark.php?d=viafrance.store Viagra sans ordonnance livraison 24h

Quand une femme prend du Viagra homme Viagra 100mg prix and Viagra gГ©nГ©rique sans ordonnance en pharmacie Viagra homme prix en pharmacie sans ordonnance

https://drugswithoutdrprescriptions.com/# online pharmacy no scripts

sildenafilo 100mg precio farmacia: comprar viagra online en andorra - sildenafilo 100mg sin receta

sildenafilo 100mg precio farmacia: se puede comprar sildenafil sin receta - sildenafilo 100mg precio espaГ±a

canadian pharmacy antiobotics without perscription: drugs without dr prescriptions - online pharmacies without an rx

https://drugswithoutdrprescriptions.com/# canadian drugs

canadian drugstore pharmacy pain meds online without doctor prescription or canadian neighborhood pharmacy

http://hamptonssaunders.net/__media__/js/netsoltrademark.php?d=drugswithoutdrprescriptions.com discount mail order pharmacy

canada drugs without prescription legitimate canadian pharmacies online and mexican pharmacies prescription drug prices

canadian mail order pharmacy vipps accredited online pharmacy or online canadian discount pharmacy

http://itsyourguess.com/__media__/js/netsoltrademark.php?d=drugswithoutdrprescriptions.com my canadian family pharmacy

best online pharmacy without prescription drugs canada and drug stores canada pharmacy review

https://drugswithoutdrprescriptions.com/# certified canadian international pharmacy

online pharmacies canada reviews: drugs without dr prescriptions - canadian mail order pharmacies

https://drugswithoutdrprescriptions.com/# canadian pharmacy reviews

viagra entrega inmediata: sildenafilo 100mg farmacia - viagra para hombre precio farmacias

online meds no rx reliable: get a prescription without seeing a doctor - canadian pharmacy azithromycin

https://drugswithoutdrprescriptions.com/# online pharmacies in canada

my canadian family pharmacy prescription drugs without doctor approval best canadian online pharmacy reviews

se puede comprar viagra sin receta: viagra online cerca de la coruГ±a - viagra 100 mg precio en farmacias

cheap drugs canada: free online doctor prescription USA - canadian neighborhood pharmacy

https://drugswithoutdrprescriptions.com/# canada prescription

mexican drugstore online get a prescription without seeing a doctor best mail order pharmacies

viagra online spedizione gratuita: viagra generico sandoz - cerco viagra a buon prezzo

https://viasenzaricetta.com/# cerco viagra a buon prezzo

viagra pfizer 25mg prezzo viagra originale recensioni kamagra senza ricetta in farmacia

viagra generico sandoz: viagra 50 mg prezzo in farmacia - viagra originale in 24 ore contrassegno

https://viasenzaricetta.com/# viagra naturale in farmacia senza ricetta

viagra online spedizione gratuita cialis farmacia senza ricetta miglior sito dove acquistare viagra

п»їviagra prezzo farmacia 2023: viagra originale recensioni - gel per erezione in farmacia

https://viasenzaricetta.com/# viagra online spedizione gratuita

farmacia senza ricetta recensioni viagra ordine telefonico viagra 100 mg prezzo in farmacia

viagra generico in farmacia costo: viagra acquisto in contrassegno in italia - viagra consegna in 24 ore pagamento alla consegna

https://viasenzaricetta.com/# cialis farmacia senza ricetta

viagra naturale: viagra originale in 24 ore contrassegno - dove acquistare viagra in modo sicuro

https://viasenzaricetta.com/# pillole per erezione immediata

farmacia senza ricetta recensioni: pillole per erezione in farmacia senza ricetta - viagra ordine telefonico

https://viasenzaricetta.com/# dove acquistare viagra in modo sicuro

viagra originale in 24 ore contrassegno viagra online spedizione gratuita cerco viagra a buon prezzo

siti sicuri per comprare viagra online viagra 50 mg prezzo in farmacia viagra generico recensioni

viagra naturale in farmacia senza ricetta: viagra generico in farmacia costo - viagra subito

https://viasenzaricetta.com/# pillole per erezione in farmacia senza ricetta

viagra cosa serve esiste il viagra generico in farmacia viagra ordine telefonico

viagra pfizer 25mg prezzo: kamagra senza ricetta in farmacia - viagra online spedizione gratuita

https://viasenzaricetta.com/# viagra online consegna rapida

zithromax tablets: zithromax without prescription - zithromax price south africa

https://prednisonesale.pro/# prednisone brand name us

zithromax for sale cheap cheap zithromax zithromax 500 tablet

prednisone 5 tablets: prednisone otc price - prednisone without prescription.net

https://prednisonesale.pro/# where to buy prednisone in canada

prednisone 1 mg for sale how much is prednisone 10 mg buy prednisone online without a script

http://zithromax.pro/# buy cheap zithromax online

where to get cytotec pills: buy cytotec online - Abortion pills online

http://doxycyclinesale.pro/# doxycycline 200 mg cost

order cytotec online buy cytotec in usa buy cytotec in usa

cytotec online buy cytotec over the counter or buy cytotec pills online cheap

http://tidehousebooks.net/__media__/js/netsoltrademark.php?d=cytotecsale.pro buy cytotec over the counter

buy cytotec buy cytotec online and buy cytotec online fast delivery order cytotec online

zithromax 500mg over the counter: buy zithromax online - buy zithromax online cheap

https://zithromax.pro/# zithromax 1000 mg pills

by prednisone w not prescription prednisone 12 tablets price prednisone tablet 100 mg

prednisone 3 tablets daily: prednisone prices - generic prednisone for sale

http://prednisonesale.pro/# buying prednisone

how to get generic clomid without prescription get clomid now buy generic clomid without insurance

how to get doxycycline without prescription: doxycycline 100mg tablets no prescription - doxycycline rx

https://prednisonesale.pro/# prednisone prescription for sale

best price for prescription doxycycline 631311 doxycycline doxycycline price comparison

prednisone 20mg prednisone 2.5 mg daily or prednisone 1 tablet

http://pornrating.com/__media__/js/netsoltrademark.php?d=prednisonesale.pro prednisone 60 mg

buy 10 mg prednisone how to buy prednisone online and prednisone 10 mg coupon price of prednisone 5mg

zithromax for sale online zithromax azithromycin or zithromax azithromycin

http://ww17.picturemania.com/__media__/js/netsoltrademark.php?d=zithromax.pro generic zithromax india

zithromax online no prescription generic zithromax azithromycin and zithromax price south africa zithromax 1000 mg pills

doxycycline prescription australia: where to buy doxycycline over the counter - buy doxycycline online no prescription

http://doxycyclinesale.pro/# where can i buy doxycycline over the counter

buy cytotec pills buy cytotec over the counter cytotec abortion pill

cialis generic best price Best natural alternative in efficacy depends on days for the ascending limb of primary hyperparathyroidism to urinate and cold

Cytotec 200mcg price: buy cytotec online fast delivery - Misoprostol 200 mg buy online

http://clomidsale.pro/# where to get clomid no prescription

buy cytotec over the counter where to get cytotec pills buy cytotec over the counter

where can i get doxycycline over the counter doxycycline 100mg tablet price in india or buy doxycycline online usa

http://susanfrank.com/__media__/js/netsoltrademark.php?d=doxycyclinesale.pro doxycycline 250 mg tabs

buy doxycycline online without a prescription doxycycline vibramycin and cheapest doxycycline 100mg purchase doxycycline

http://clomidsale.pro/# where to get cheap clomid

prednisone 30 mg daily: buy prednisone without prescription - prednisone 20 mg generic

http://prednisonesale.pro/# 10 mg prednisone

prednisone over the counter south africa prednisone rx coupon prednisone uk price

where to get generic clomid without dr prescription: buy clomid over the counter - where to get clomid pills

http://doxycyclinesale.pro/# doxycycline prescription uk

can i purchase clomid no prescription buy clomid buy clomid pills

can you get generic clomid pills: buy clomid over the counter - how to get cheap clomid without rx

http://zithromax.pro/# where to buy zithromax in canada

buy doxycycline without prescription uk doxycycline hyclate capsules buy doxycycline without prescription uk

how to get doxycycline online: can you buy doxycycline over the counter nz - doxycycline drug

http://zithromax.pro/# buy zithromax online australia

buy cytotec online cytotec pills buy online cytotec buy online usa

zithromax cost australia: azithromycin over the counter - generic zithromax 500mg india

https://cytotecsale.pro/# purchase cytotec

zithromax capsules 250mg azithromycin over the counter zithromax purchase online

doxycycline 50 mg cap: doxycycline 400 mg daily - oral doxycycline

http://zithromax.pro/# zithromax 1000 mg online

doxycycline order online doxycycline 100mg best price how to get doxycycline online

zithromax azithromycin where to get zithromax over the counter or zithromax generic cost

http://delatum.com/__media__/js/netsoltrademark.php?d=zithromax.pro can you buy zithromax over the counter

zithromax buy online where can i buy zithromax uk and zithromax for sale online buy zithromax online with mastercard

cytotec buy online usa: buy cytotec pills online cheap - Misoprostol 200 mg buy online

http://prednisonesale.pro/# prednisone 2.5 mg price

can i buy zithromax over the counter in canada zithromax without prescription can i buy zithromax over the counter

http://zithromax.pro/# purchase zithromax online

where buy clomid prices: buy clomid over the counter - can i order generic clomid pill

http://prednisonesale.pro/# buying prednisone without prescription

doxycycline 300 mg daily doxycycline cheap canada cost doxycycline tablets uk

doxycycline price uk doxycycline 50 mg price uk or doxycycline hyclate 100 mg capsules

http://kyowa-kirin-ca.info/__media__/js/netsoltrademark.php?d=doxycyclinesale.pro doxycycline 100mg capsules uk

order doxycycline without prescription buy doxycycline medicine and average cost of doxycycline doxycycline india buy

where to get cytotec pills: buy cytotec over the counter - buy cytotec in usa

http://zithromax.pro/# where can i buy zithromax uk

cost generic clomid without a prescription order cheap clomid without rx can i order cheap clomid prices

can you buy clomid prices: cheap clomid - can i purchase clomid without prescription

https://prednisonesale.pro/# 200 mg prednisone daily

doxycycline order online uk doxycycline 100mg tabs doxycycline 100mg

buy cytotec in usa: buy cytotec over the counter - buy cytotec

https://cytotecsale.pro/# buy cytotec pills online cheap

how to buy cheap clomid tablets cheap clomid can i order clomid tablets

generic zithromax over the counter: zithromax for sale online - zithromax capsules 250mg

https://doxycyclinesale.pro/# doxycycline 100mg online

where to buy generic clomid where to buy clomid prices buying cheap clomid without insurance

where can i buy clomid without prescription: buy clomid over the counter - can you buy cheap clomid without rx

http://prednisonesale.pro/# generic over the counter prednisone

cytotec abortion pill Cytotec 200mcg price п»їcytotec pills online

canada buy prednisone online: prednisone 20mg online without prescription - cost of prednisone 10mg tablets

http://zithromax.pro/# where can i buy zithromax uk

doxy 200 doxycycline 100 mg price uk doxycycline brand name canada

80 mg prednisone daily: generic prednisone tablets - prednisone pharmacy

http://doxycyclinesale.pro/# doxycycline 75 mg price

cost of doxycycline doxycycline 100mg otc doxycycline pills over the counter

buy misoprostol over the counter: order cytotec online - buy cytotec online fast delivery

https://doxycyclinesale.pro/# doxycycline 100mg tablets cost

zithromax prescription buy zithromax online zithromax without prescription

where can i buy doxycycline in singapore doxycycline 1mg or doxycycline 300 mg cost

http://askaceo.net/__media__/js/netsoltrademark.php?d=doxycyclinesale.pro can you buy doxycycline over the counter in india

doxycycline 20 mg doxycycline 100mg cap price and where can i get doxycycline doxycycline 100mg price australia

Abortion pills online: purchase cytotec - buy cytotec over the counter

https://prednisonesale.pro/# buy prednisone 40 mg

cytotec buy online usa Cytotec 200mcg price buy misoprostol over the counter

doxycycline 75 mg tab: doxycycline cost - doxycycline for sale uk

https://doxycyclinesale.pro/# 10 mg doxycycline

100 mg prednisone daily prednisone 10 mg price brand prednisone

buying cheap clomid no prescription: buy clomid - cost cheap clomid no prescription

http://doxycyclinesale.pro/# doxycycline 1000 mg best buy

prednisone pill 10 mg buy prednisone no prescription prednisone

pharmacies withour prescriptions

https://alglobalpharma.com/

safe online pharmacies in canada

buy prednisone 40 mg: 100 mg prednisone daily - order prednisone 10 mg tablet

http://zithromax.pro/# zithromax generic cost

buy doxycycline monohydrate doxycycline 100mg capsules price in india doxycycline 150 mg cost comparison

where can i get prednisone where can i buy prednisone without prescription or prednisone uk

http://wellcomp.info/__media__/js/netsoltrademark.php?d=prednisonesale.pro prednisone pill 10 mg

prednisone buy online nz prednisone coupon and 10 mg prednisone tablets prednisone uk

get generic clomid pills: can you buy cheap clomid - how can i get generic clomid without dr prescription

http://prednisonesale.pro/# buy prednisone from india

buy azithromycin zithromax generic zithromax azithromycin zithromax over the counter uk

can i purchase cheap clomid without rx: buy clomid over the counter - can i get cheap clomid without prescription

https://cytotecsale.pro/# п»їcytotec pills online

buy cytotec pills where to get cytotec pills cytotec buy online usa

buy prednisone without prescription: prednisone otc price - prednisone 10 mg tablets

http://doxycyclinesale.pro/# doxycycline 225 mg

prednisone 60 mg buying prednisone from canada prednisone 50 mg tablet cost

generic doxycycline: doxycycline for sale uk - doxycycline nz

http://clomidsale.pro/# how to buy clomid for sale

zithromax over the counter buy zithromax online zithromax price canada

canada drug pharmacy canadian drug canadian pharmacy ltd

buy medicines online in india buy prescription drugs from india or pharmacy website india

http://crescenzoshoots.com/__media__/js/netsoltrademark.php?d=indiaph.store buy prescription drugs from india

indian pharmacy indian pharmacies safe and india online pharmacy india pharmacy mail order

canadian compounding pharmacy: legal canadian pharmacy online - pharmacy rx world canada

mexico drug stores pharmacies mexican mail order pharmacies mexico pharmacies prescription drugs

is canadian pharmacy legit cheapest pharmacy canada or best mail order pharmacy canada

http://woodharbinger.info/__media__/js/netsoltrademark.php?d=canadianph.pro canada discount pharmacy

canadian pharmacy legit canadian pharmacy and canadian pharmacy checker canadian 24 hour pharmacy

buying prescription drugs in mexico online: medication from mexico pharmacy - buying from online mexican pharmacy

reputable indian pharmacies: indian pharmacies shipping to usa - online pharmacy india

top 10 online pharmacy in india overseas pharmacies shipping to usa canadian pharmacy india

best online pharmacies in mexico: buying from online mexican pharmacy - best online pharmacies in mexico

top canadian pharmacies

https://alglobalpharma.com/

pharmacy canada online

buying from canadian pharmacies canadian pharmacy no scripts or adderall canadian pharmacy

http://neccessories.com/__media__/js/netsoltrademark.php?d=canadianph.pro best canadian pharmacy to order from

canadian pharmacy canada drugs online reviews and canadian pharmacies comparison my canadian pharmacy

canadian pharmacy prices onlinepharmaciescanada com reputable canadian online pharmacy

zithromax without prescription: zithromax drug - zithromax 250 mg

buy ciprofloxacin tablets cipro or purchase cipro

http://tuxedorental.tv/__media__/js/netsoltrademark.php?d=ciprofloxacin.pro п»їcipro generic

where can i buy cipro online ciprofloxacin generic and buy ciprofloxacin tablets buy cipro online

buy doxycycline online: vibramycin 100 mg - buy doxycycline online uk

buy antibiotics over the counter buy antibiotics from canada or buy antibiotics over the counter

http://juniordosamba.com/__media__/js/netsoltrademark.php?d=antibiotics.pro best online doctor for antibiotics

cheapest antibiotics over the counter antibiotics and buy antibiotics buy antibiotics for uti

ciprofloxacin 500 mg tablet price: ciprofloxacin 500mg buy online - cipro ciprofloxacin

canada drugs online reviews

https://canadiandailymeds.com/

canada pharmacy world

ciprofloxacin mail online: cipro ciprofloxacin - buy cipro

doxycycline 100mg online: where to get doxycycline - doxycycline 100mg

pharmacy prices compare

https://canadianpharmsl.com/

cheap pharmacy

buy generic zithromax no prescription: zithromax online paypal - zithromax tablets for sale

http://azithromycin.pro/# zithromax antibiotic

doxycycline generic price of doxycycline buy generic doxycycline

buy cipro online: ciprofloxacin order online - ciprofloxacin mail online

safe reliable canadian pharmacy: canada discount pharmacy - canadian pharmacy cheap

mexican rx online: mexican mail order pharmacies - best online pharmacies in mexico

best online doctor for antibiotics: Over the counter antibiotics for infection - Over the counter antibiotics for infection

http://antibiotics.pro/# buy antibiotics from canada

vibramycin 100 mg doxycycline order online doxycycline 200 mg

https://overthecounter.pro/# over the counter insulin

http://overthecounter.pro/# over the counter medicine for uti

sleep aids over the counter over the counter ed medication cvs over the counter asthma inhaler

arthritis medicine for dogs over the counter econazole nitrate cream over the counter or over the counter anti nausea

http://www.creatividude.net/__media__/js/netsoltrademark.php?d=overthecounter.pro over the counter oral thrush treatment

is zofran over the counter over the counter anti nausea and over the counter ed pills instant female arousal pills over the counter

http://overthecounter.pro/# over the counter medicine for uti

potassium supplements over-the-counter: over-the-counter drug - over the counter pain meds

over the counter essentials login: over the counter medication - bronchial inhalers over the counter

http://overthecounter.pro/# over the counter cialis

best over the counter ed pills that work fast best sleeping pills over the counter or over the counter pink eye medicine

http://theverbalweb.com/__media__/js/netsoltrademark.php?d=overthecounter.pro cvs over the counter asthma inhaler

over the counter asthma inhaler is zofran over the counter and over the counter uti meds over the counter uti medicine

https://overthecounter.pro/# oral thrush treatment over the counter

zofran over the counter: over the counter drugs - naproxen 500mg over the counter

https://overthecounter.pro/# best over the counter yeast infection treatment

best over the counter hair color: over the counter medication - over the counter antihistamine

https://overthecounter.pro/# best allergy medications over-the-counter

over the counter birth control: over the counter drugs - over the counter arthritis medicine

http://overthecounter.pro/# over the counter steroid cream

https://overthecounter.pro/# over the counter appetite suppressant

over the counter allergy medicine over the counter uti meds or over the counter

http://manufacturingboard.com/__media__/js/netsoltrademark.php?d=overthecounter.pro guaranteed suicide over the counter

over the counter uti meds over the counter erectile pills at walgreens and best over the counter toenail fungus treatment pills like viagra over the counter cvs

http://overthecounter.pro/# over the counter sinus medicine

over the counter erectile dysfunction pills: over the counter ed meds - over the counter steroid cream

best appetite suppressant over the counter: over the counter ed meds - appetite suppressants over the counter

https://overthecounter.pro/# over the counter arthritis medicine

http://overthecounter.pro/# silvadene cream over the counter

allergy medications over-the-counter best over the counter cough medicine or over the counter acid reflux medicine

http://sitiooficial.com/__media__/js/netsoltrademark.php?d=overthecounter.pro over the counter cough medicine

over the counter inhaler walmart uti over the counter medicine and over the counter erectile pills at walgreens over the counter diet pills that work

chlorhexidine mouthwash over the counter: over the counter erectile dysfunction pills - over the counter eye drops for pink eye

https://overthecounter.pro/# best allergy medications over-the-counter

https://overthecounter.pro/# over the counter muscle relaxer

apoquel over the counter substitute: over the counter erection pills - male enhancement pills over the counter

best ed pills online: medication for ed dysfunction - cheap ed pills

mail order prescription drugs online meds no rx reliable or trusted canadian pharmacies

http://ninetyninehudsonblvdny.com/__media__/js/netsoltrademark.php?d=pillswithoutprescription.pro mail order pharmacy canada

online canadian pharmacy no prescription canada pharmacy estrogen without prescription and trust online pharmacy rx online

compare prices prescription drugs overseas online pharmacies online pharmacy no prescription

top erection pills: ed meds online - the best ed pill

prescription drugs without doctor: certified canadian international pharmacy - prescription drug discounts

prescription drug prices comparison online pharmacies no prescriptions online pharmacy usa

mexico pharmacy order online online drugstore service canada or canadian pharmacy no rx needed

http://adolfosamudio.net/__media__/js/netsoltrademark.php?d=pillswithoutprescription.pro top rated online pharmacy

canadian pharmacy direct canadian pharmacy selling viagra and north canadian pharmacy prescription drug pricing

http://edpills.pro/# herbal ed treatment

cure ed: over the counter erectile dysfunction pills - new ed treatments

ed meds ed meds online male ed pills

mexican border pharmacies shipping to usa: certified canadian international pharmacy - certified canadian international pharmacy

india pharmacy mail order top 10 online pharmacy in india or indian pharmacy paypal

http://ibiboairlinebooking.in/__media__/js/netsoltrademark.php?d=indianpharmacy.pro pharmacy website india

best online pharmacy india cheapest online pharmacy india and Online medicine home delivery india pharmacy

https://indianpharmacy.pro/# india pharmacy

buy online sildenafil - cheap sildenafil sildenafil 50mg uk

http://vsildenafil.pro/# 10 sildenafil

sildenafil 100 coupon buy sildenafil 100mg online sildenafil pills 50 mg

buy tadalafil uk - tadalafil without prescription best price tadalafil 20 mg

http://edmeds.pro/# cheap erectile dysfunction pill

tadalafil 20mg price in india buy tadalafil online buy tadalafil 5mg online

best price for tadalafil 20 mg buy generic tadalafil online uk or tadalafil 2.5 mg generic

http://waltermorales.com/__media__/js/netsoltrademark.php?d=tadalafilfst.com tadalafil 5mg in india

buy tadalafil in usa buy tadalafil 20mg uk and tadalafil tablets 20 mg cost canadian pharmacy generic tadalafil

canada tadalafil generic - tadalafil 20mg lowest price tadalafil generic price

http://vsildenafil.pro/# buy sildenafil 20 mg

tadalafil cheap tadalafil canada tadalafil price

erectile dysfunction medicines buy ed pills online - men's ed pills

http://vsildenafil.pro/# sildenafil compare prices

buying drugs from canada canadian mail order pharmacy canada drugs online reviews

canadianpharmacy com canadian pharmacy uk delivery or northern pharmacy

http://treadstonegroup.us/__media__/js/netsoltrademark.php?d=pharmst.pro safe online pharmacies in canada

safe canadian pharmacies cialis online pharmacy and canadian pharmacy no scripts discount pharmacy online

mexican pharmacy online: online pharmacy without scripts - prescription drugs online

https://tadalafilfst.com/# tadalafil tablets 20 mg india

cheapest pharmacy for prescription drugs mexican pharmacy online pharmacy in canada

trusted canadian pharmacy: canadian pharmacy meds - canadian pharmacy coupon code

https://vsildenafil.pro/# sildenafil generic brand name

natural ed medications cheap erectile dysfunction pill best male ed pills

canadian drugs pharmacy: canadian pharmacy without prescription - med pharmacy

http://tadalafilfst.com/# tadalafil tablets

canadian pharmacy online store canadian mail order pharmacy canadian pharmacy viagra 50 mg

sildenafil 50mg buy sildenafil 10 mg or sildenafil 100mg price india

http://berrybuckmillsstipe.com/__media__/js/netsoltrademark.php?d=vsildenafil.pro sildenafil brand name

generic sildenafil usa viagra sildenafil 100mg and buy sildenafil online no prescription sildenafil citrate tablets 100mg

mexican pharmacy online: canadian online pharmacy no prescription - express scripts com pharmacies

https://edmeds.pro/# best ed medication

canadian pharmacy online cialis canadian pharmacy without prescription best mail order pharmacy canada

sildenafil pharmacy costs - buy sildenafil from canada sildenafil 50 mg online

http://vsildenafil.pro/# best rx prices for sildenafil

tadalafil capsules 21 mg tadalafil without prescription generic tadalafil 10mg

buy erection pills best treatment for ed or ed dysfunction treatment

http://dishnetworkmail.net/__media__/js/netsoltrademark.php?d=edmeds.pro non prescription ed pills

cheap erectile dysfunction pill best ed drug and top ed pills non prescription ed drugs

tadalafil tablet buy online how much is tadalafil or tadalafil 5 mg coupon

http://marisasbistroofplenty.net/__media__/js/netsoltrademark.php?d=tadalafilfst.com canadian online pharmacy tadalafil

cheap 10 mg tadalafil lowest price tadalafil and tadalafil soft gel tadalafil - generic

sildenafil generic costs - sildenafil citrate over the counter buy sildenafil 100mg online

http://vsildenafil.pro/# sildenafil coupon 100 mg

buy tadalafil from india tadalafil canada tadalafil best price uk

https://edmeds.pro/# best male ed pills

order sildenafil from india - purchase sildenafil 100 mg buy online sildenafil

http://pharmst.pro/# pharmacy home delivery

pharmacy today canadian family pharmacy canadien pharmacies

how can i get sildenafil purchase sildenafil pills or sildenafil singapore

http://mediastats.us/__media__/js/netsoltrademark.php?d=vsildenafil.pro generic sildenafil without a prescription

lowest price sildenafil sildenafil cost uk and cost of 100mg sildenafil buy sildenafil 100mg online

walgreens online pharmacy online pharmacy australia or no prescription needed pharmacy

http://wwwkohlsfeedback.com/__media__/js/netsoltrademark.php?d=pharmst.pro online pharmacy

your pharmacy online 24 hr pharmacy and reputable online pharmacy online shopping pharmacy india

sildenafil otc - canadian online pharmacy sildenafil where to buy sildenafil over the counter

http://vsildenafil.pro/# buy sildenafil viagra

canada online pharmacy us online pharmacy canadian pharmacy world coupons

PMID 19519291 Free PMC article finasteride generic uk

erection pills online ed meds online without doctor prescription buy ed pills online

buy canadian drugs online: international pharmacies that ship to the usa - cheap pharmacy

canadian pharmacy world - drugs without a doctor s prescription legitimate canadian mail order pharmacy

meds without a doctor s prescription canada - legitimate canadian mail order pharmacies pharmacy online

most reliable online pharmacies - overseas no rx drugs online canadian pharma companies

https://fastdeliverypill.com/# international pharmacies that ship to the usa

discount pharmacy coupons - international pharmacies that ship to the usa canadian pharmaceuticals online reviews

doxycycline mexican pharmacy non prescription canadian pharmacy or reliable canadian online pharmacy

http://pkpworldwide.com/__media__/js/netsoltrademark.php?d=fastdeliverypill.com online ed medication no prescription

canadain pharmacy no prescription cheap rx drugs and canadian pharmacy tadalafil best canadian pharmacy cialis

https://fastdeliverypill.com/# price prescriptions

canadian rx pharmacy online - international pharmacies that ship to the usa canadian pharmacies list

cheap drugs online canada drug online or canadian pharmacy shop

http://drsheila.net/__media__/js/netsoltrademark.php?d=fastdeliverypill.com online pharmacies canada

mexican pharmacy cialis reputable mexican pharmacies and canadian pharmacy delivery reliable canadian online pharmacy

https://fastdeliverypill.com/# northwestpharmacy com

legitimate canadian pharmacy online cross border pharmacy canada or canada pharmacy online

http://columbustransportationjobs.com/__media__/js/netsoltrademark.php?d=fastdeliverypill.com canadian pharmacy cialis

24 hour pharmacy canada rx pharmacy and pharmacy store online canadian pharmacy reviews

online pharmacy store: order prescription medicine online without prescription - discount mail order pharmacy

http://cialiswithoutprescription.pro/# sell of cialis

reputable indian online pharmacy india pharmacy mail order pharmacy india

online shopping pharmacy india: reputable indian pharmacies - Online medicine home delivery

http://cialiswithoutprescription.pro/# cialis on line

indian pharmacy paypal online pharmacy india india pharmacy

http://canadiandrugs.pro/# best canadian online pharmacy

dapoxetine cialis american express generic cialis india or pharmacy 365 cialis

http://townandcountrymag.biz/__media__/js/netsoltrademark.php?d=cialiswithoutprescription.pro generic levitra and cialis in australia

cheap cialis online generic cialis 20 mg tablets and prices and buy cialis 20mg viagra cialis levitra trial pack

cialis store in qatar order generic cialis by phone or original cialis online